#SVM

.

.

.

.

.

.

.

.

.

.

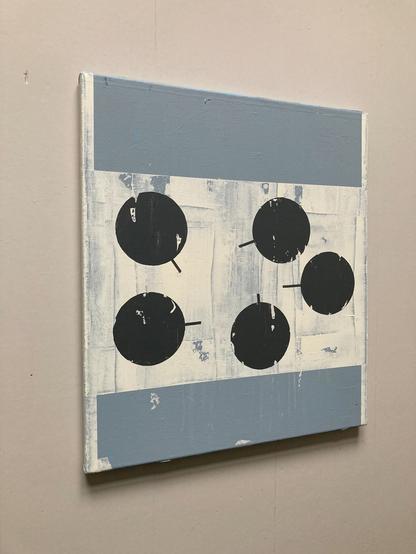

Price range € 1.250 - € 1.500

.

#beeldendekunst #hedendaagseschilderkunst #kunst #hedendaagsekunst #contemporarypainting #contemporaryart #modernpainting #modernart #minimalart #abstractart #figurativeart #styleless #thenetherlands #zeitgenössischekunst #zeitgenössischemalerei #steven_van_meurs #stevenvanmeurs #svm

Почему Andrej Karpathy использует SVM в 2026 году (и вам тоже стоит)

На arXiv каждый день публикуются сотни статей по машинному обучению. Читать всё — нереально, а пропустить что-то важное — обидно. Andrej Karpathy, бывший Director of AI в Tesla и соавтор курса Stanford CS231n, решил эту проблему неожиданным способом. Он выбрал не BERT, не GPT и не какой-нибудь модный трансформер. Он остановился на добром старом SVM — алгоритме, которому уже несколько десятков лет. И знаете что? Это работает настолько хорошо, что используется даже в академических системах. В этой статье мы разберём, как устроено его решение, почему «примитивный» подход работает лучше сложных нейросетей, и когда вам тоже стоит выбрать SVM вместо трансформера. Давайте разбираться!

https://habr.com/ru/articles/990386/

#SVM #Andrej_Karpathy #TFIDF #машинное_обучение #Support_Vector_Machine #нейросети #алгоритмы_классификации

.

.

.

.

.

.

.

.

.

.

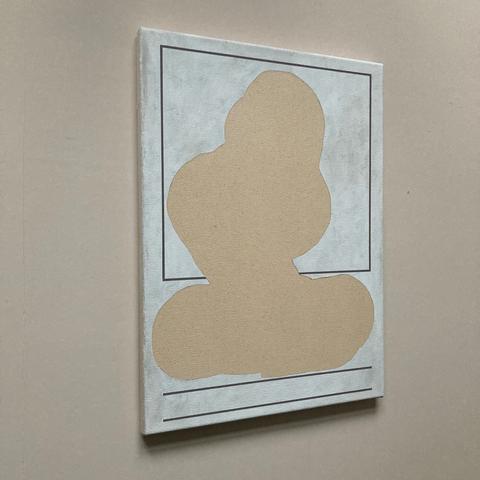

Price range € 1.000 - € 1.250

.

#beeldendekunst #hedendaagseschilderkunst #kunst #hedendaagsekunst #contemporarypainting #contemporaryart #modernpainting #modernart #minimalart #abstractart #figurativeart #styleless #thenetherlands #zeitgenössischekunst #zeitgenössischemalerei #steven_van_meurs #stevenvanmeurs #svm

How to Use Support Vector Machines (SVM) in Python

This post shows an end-to-end workflow: prepare features, tune C/γ safely, validate with the right metrics for imbalance, and visualize how the boundary changes—so the model is usable for real triage.

:medium: https://hasanaligultekin.medium.com/how-to-use-support-vector-machines-svm-in-python-20528553345d

#Python #MachineLearning #SVM #FraudDetection #DataScience #medium #ai #programming

@ai @programming @towardsdatascience

@pythonclcoding @theartificialintelligence @socialsciences @medium

.

.

.

.

.

.

.

.

.

.

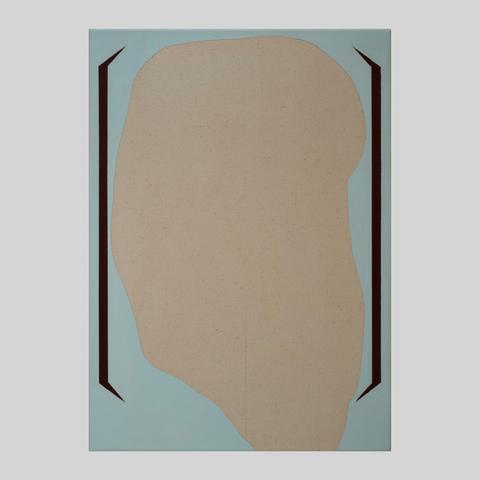

Price range € 750 - € 1.000

.

#beeldendekunst #hedendaagseschilderkunst #kunst #hedendaagsekunst #contemporarypainting #contemporaryart #modernpainting #modernart #minimalart #abstractart #figurativeart #styleless #thenetherlands #zeitgenössischekunst #zeitgenössischemalerei #steven_van_meurs #stevenvanmeurs #svm

.

.

.

.

.

.

.

.

.

.

Price range € 500 - € 750

.

#beeldendekunst #hedendaagseschilderkunst #kunst #hedendaagsekunst #contemporarypainting #contemporaryart #modernpainting #modernart #minimalart #abstractart #figurativeart #styleless #thenetherlands #zeitgenössischekunst #zeitgenössischemalerei #steven_van_meurs #stevenvanmeurs #svm

.

.

.

.

.

.

.

.

.

.

Price range € 1.000- € 1.250

.

#beeldendekunst #hedendaagseschilderkunst #kunst #hedendaagsekunst #contemporarypainting #contemporaryart #modernpainting #modernart #minimalart #abstractart #figurativeart #styleless #thenetherlands #zeitgenössischekunst #zeitgenössischemalerei #steven_van_meurs #stevenvanmeurs #svm

.

.

.

.

.

.

.

.

.

.

Price range € 850- € 1.000

.

#beeldendekunst #hedendaagseschilderkunst #kunst #hedendaagsekunst #contemporarypainting #contemporaryart #modernpainting #modernart #minimalart #abstractart #figurativeart #styleless #thenetherlands #zeitgenössischekunst #zeitgenössischemalerei #steven_van_meurs #stevenvanmeurs #svm

When You Need Clustering or SVM Developers for ML Projects

Not sure when your ML project requires expert help? Clustering specialists and SVM developers can make a huge difference when working with complex datasets, uncovering hidden patterns, or building high-accuracy predictive models.

📌 Read the full article on the Amplework blog: https://www.amplework.com/blog/when-you-need-clustering-or-svm-developers/

#MachineLearning #Clustering #SVM #DataScienceExperts #MLProjects #AIEngineering #PredictiveModels #ScalableML #AIDevelopment

Prediction Of Cryptocurrency Prices Using LSTM, SVM And Polynomial Regre... https://youtu.be/ElBgDXy4nBw?si=PccGzt2RHB_MZWX- via @YouTube #svm #lstm #forecasting #polynomialregression #cryptocurrency #supportvectormachine

https://www.youtube.com/watch?v=ElBgDXy4nBw&utm_source=flipboard&utm_medium=activitypub

Posted into NOSABLOGGISTA @nosabloggista-OluOyekanmi

.

.

.

.

.

.

.

.

.

.

Price range € 850- € 1.000

.

#beeldendekunst #hedendaagseschilderkunst #kunst #hedendaagsekunst #contemporarypainting #contemporaryart #modernpainting #modernart #minimalart #abstractart #figurativeart #styleless #thenetherlands #zeitgenössischekunst #zeitgenössischemalerei #steven_van_meurs #stevenvanmeurs #svm

.

.

.

.

.

.

.

.

.

.

Price range € 1.250- € 1.500

.

#beeldendekunst #hedendaagseschilderkunst #kunst #hedendaagsekunst #contemporarypainting #contemporaryart #modernpainting #modernart #minimalart #abstractart #figurativeart #styleless #thenetherlands #zeitgenössischekunst #zeitgenössischemalerei #steven_van_meurs #stevenvanmeurs #svm

Im Interview mit Frau Ursula Schade, eine Urberlinerin Jahrgang 1947 und Weddingerin par excellence, spreche ich über ihre 50 Jahre im Ehrenamt, die sie hier geleistet hat. Sie lebt von nun 78 Lebensjahren bereits 61 Jahre im Wedding, genauer im Gesundbrunnen nahe der Bornholmer Straße, dort, wo damals die großen Grenzschilder standen. 50 Jahre lang hat sie sich für das Soziale in unserer Stadt und für unsere Gesellschaft eingesetzt.

[…]

.

.

.

.

.

.

.

.

.

.

Price range € 1.250- € 1.500

.

#beeldendekunst #hedendaagseschilderkunst #kunst #hedendaagsekunst #contemporarypainting #contemporaryart #modernpainting #modernart #minimalart #abstractart #figurativeart #styleless #thenetherlands #zeitgenössischekunst #zeitgenössischemalerei #steven_van_meurs #stevenvanmeurs #svm

.

.

.

.

.

.

.

.

.

.

Price range € 1.250- € 1.500

.

#beeldendekunst #hedendaagseschilderkunst #kunst #hedendaagsekunst #contemporarypainting #contemporaryart #modernpainting #modernart #minimalart #abstractart #figurativeart #styleless #thenetherlands #zeitgenössischekunst #zeitgenössischemalerei #steven_van_meurs #stevenvanmeurs #svm

.

.

.

.

.

.

.

.

.

.

Price range € 1.000 - € 1.100

.

#beeldendekunst #hedendaagseschilderkunst #kunst #hedendaagsekunst #contemporarypainting #contemporaryart #modernpainting #modernart #minimalart #abstractart #figurativeart #styleless #thenetherlands #zeitgenössischekunst #zeitgenössischemalerei #steven_van_meurs #stevenvanmeurs #svm

.

.

.

.

.

.

.

.

.

.

Price range € 750 - € 1.000

.

#beeldendekunst #hedendaagseschilderkunst #kunst #hedendaagsekunst #contemporarypainting #contemporaryart #modernpainting #modernart #minimalart #abstractart #figurativeart #styleless #thenetherlands #zeitgenössischekunst #zeitgenössischemalerei #steven_van_meurs #stevenvanmeurs #svm

🌘 Embedding-Aware 量子-古典 SVM 於可擴展量子機器學習

➤ 借鑒 Transformer 嵌入,開創可擴展量子 SVM 新紀元

✤ https://arxiv.org/abs/2508.00024

本研究提出一種創新的量子-古典機器學習方法,透過結合視覺 Transformer (ViT) 的預訓練嵌入與類別平衡的 k-means 降維技術,解決了現有量子支援向量機 (QSVM) 在處理高維量子態及硬體限制時的擴展性挑戰。實驗結果顯示,ViT 嵌入能夠顯著提升量子優勢,在 Fashion-MNIST 和 MNIST 資料集上分別帶來高達 8.02% 和 4.42% 的準確度提升,而傳統卷積神經網路 (CNN) 特徵在此方面則表現不佳。研究進一步利用 16 個量子位元的張量網路模擬(透過 cuTensorNet 實現),提供了首個系統性的證據,表明量子核優勢的表現與嵌入選擇有著關鍵的依賴關係,並揭示了 Transformer 的注意力機制與量子特徵空間之間存在重要

#量子計算 #機器學習 #SVM #嵌入 #Transformer #視覺 Transformer

.

.

.

.

.

.

.

.

.

.

Price range € 900 - € 1.200

.

#beeldendekunst #hedendaagseschilderkunst #kunst #hedendaagsekunst #contemporarypainting #contemporaryart #modernpainting #modernart #minimalart #abstractart #figurativeart #styleless #thenetherlands #zeitgenössischekunst #zeitgenössischemalerei #steven_van_meurs #stevenvanmeurs #svm