@rugk Danke. Ja, dsa k ommt. Dauert aber, weil der Code dafür noch aufgeräumt werden muss. Erstmal werden die Daten als OpenData zugänglich gemacht

@Unknowable In Mecklenburg-Vorpommern gibt es wenig Menschen und damit auch wenig relevante Bahnhöfe für die Gesamtschau. Siehe https://xkcd.com/1138/

@datenschatz Danke. Ja, OpenSource steht auf dem Zettel. Zuerst kommt eine OpenData-API zu den Daten zu Verspätungen und Ausfällen.

@Das_blaue_Pony sie könnten wenigstens Transparenz herstellen; die Daten haben sie intern ja alle. In ihren monatlichen Berichten wird über die Ausfälle kein Wort verloren. Das halte ich für unlauter.

https://www.deutschebahn.com/de/konzern/konzernprofil/zahlen_fakten/puenktlichkeitswerte-6878476

@Das_blaue_Pony ja. bzw. ich habe ich die Bahnpressestelle gefragt, ob Ausfälle in die "Pünkltichkeitswerte" einfließen und wie. Ich habe aber keine Antwort bekommen. Soweit ich das verstehe, werden Komplettausfälle bzw. Ausfälle von Halten nicht als Verspätung gezählt.

@katzentratschen mal schauen. ich denke eher darüber nach, etwas anzubieten ,dass sich jede:r so etwas selbst machen kann für welchen Bahnhof auch immer

@farshidhakimy Danke für den Hinweis. Ja, mobil ist noch nicht das gelbe vom Ei.

@JEV für verspaetung.net werden nur 18 Bahnhöfe alle 15 Minuten abefragt, das geht. Die API der Bahn liefert die Fahrpläne 5500 Bahnhöfe mit Updates alle 30 Sekunden - die alle abzugreifen wäre ne ganz andere Liga

Hier schreibe ich zu meinem Arbeitsprozess; verleihe meiner Verwunderung Ausdruck, warum journalistische Medien diesen beeindruckenden Datenschatz nicht nutzen. Und lasse mich zur Zukunft der Softwareentwicklung per #LLM („Künstliche Intelligenz" #KI) aus. https://lorenzmatzat.substack.com/p/verspaetung-punkt-net

Hieran habe ich seit langem gearbeitet: Ein Dashboard zu den Verspätungen & Ausfällen bei der #Bahn. Das entsprechende #OpenData veröffentlicht das Unternehmen in Echtzeit. Auf Mastodon gibt es täglich Infos unter @verspaetung – das Dashboard findet sich unter https://verspaetung.net

Neu bei DIVER: Wer sind die Top 100 deutschsprachigen Accounts mit den meisten Followern bei Bluesky? Interaktive Visualisierung und tägliche Zusammenfassung der 400 bis 600 Posts.

Visualisierung

https://diver.fyi/bluesky-top-100-dach-visualisation

Newsletter-Text

https://lorenzmatzat.substack.com/p/hallo-echo

NEU – Täglicher Überblick zu rechtem Framing und Agendasetting durch Apollo News um 19 Uhr: DIVER verarbeitet die täglich 20 bis 30 Textbeiträge des rechten Nachrichtenportals und behält auch dessen YouTube-Kanal im Blick. Abonnierbar per RSS oder E-Mail. https://diver.fyi/about-source/apollo-news-watch

Seit gestern gibt es NIUS-Watch: Jeden morgen wird automatisiert der YouTube-Kanal des rechten Mediums per Large Language Model ausgewertet und eine Analyse des Vortages generiert.

Hintergrund: https://lorenzmatzat.substack.com/p/nius-watch-per-ki-nach-den-rechten

NIUS-Watch: https://diver.fyi/about-source/nius-watch

Das ganze läuft bei DIVER

https://mastodon.social/@diver_fyi

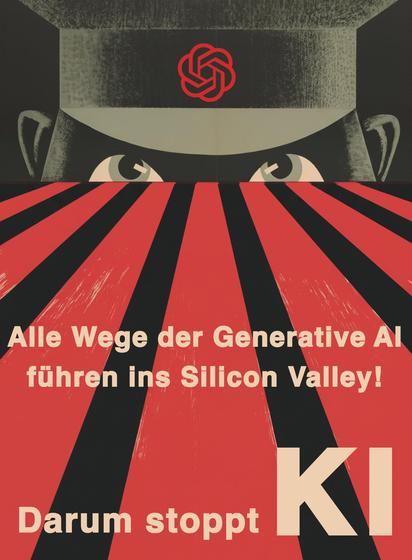

Gebloggt: Dem Bildungsbürgertum kommt in der pauschalen Ablehnung von LLM/Generative AI nicht der Gedanke, dass die Technologie weniger privilegierten Menschen Teilhabe ermöglicht. Dadurch überlasst es das Feld eben denjenigen, gegen das es vorgibt, zu sein. https://lorenzmatzat.substack.com/p/der-kontraproduktive-klassenkampf

Wie wir den Infowar der #Grokipedia sabotieren können: Nach der Verunstaltung Twitters will Elon #Musk nun die #Wikipedia beschädigen; mittels "Alternativer Fakten" will er seine menschenfeindliche Agenda in die Trainingsdaten künftiger Large Language Models #LLM einspeisen. Wir sollten dies nicht einfach hinnehmen. https://lorenzmatzat.substack.com/p/wie-wir-den-infowar-der-grokipedia

Wie lassen sich Sprachmodelle (AI/LLM) sinnvoll in der eigenen Organisation einsetzen? Kommenden Mittwoch (14.05.25, 12.30 Uhr) gebe ich 30 Minuten Input dazu - online, kostenfrei - hier anmelden: https://zukunftskultur.eu/webinar/ai-und-llm-sinnvoll-einsetzen-lunch-session-organisationsgestaltung/

Kommende Woche Mittwoch (26.3.), 12.30 bis 13.30 Uhr, gebe ich kostenfrei eine Einführung in die Nutzung von Programmier-Agenten. Via Zoom. Hier anmelden: https://zukunftskultur.eu/webinar/neue-moeglichkeiten-durch-ai-programmier-agenten-lunch-session/

@janeggers nein. aber per z.B. Lovable und Groq API (Whisper und LLama etc. begrenzt kostenfrei nutzenbar) prototypisch bastelbar. Ich mach kommenden Mittwoch ne kurze Einführung zu Coding Agenten: https://zukunftskultur.eu/webinar/neue-moeglichkeiten-durch-ai-programmier-agenten-lunch-session/

Ich habe einen Podcast-Vorkoster gebaut. So erhalte ich automatisiert Zusammenfassungen und Einordnungen zu Podcast-Folgen. Mehr zum Entstehungsprozess, Gedanken zu automatisierten Redaktion und wie ich das alleine mit Coding Agents umgesetzt habe: https://lorenzmatzat.substack.com/p/der-podcast-vorkoster